Les grands éditeurs de plates-formes dans le cloud s’adaptent irrésistiblement à l’évolution majeure qu’est l’edge computing dans le domaine de l’Internet des objets. Un paradigme informatique récent que L’Embarqué évoque dans ses colonnes depuis deux ou trois ans et qui consiste à implémenter certains processus décisionnels au plus près des données générées par lesdits objets. C’est-à-dire à l’endroit où ils se connectent au réseau, au niveau de passerelles, de concentrateurs, de microserveurs, voire des systèmes embarqués eux-mêmes pour peu qu’ils disposent de suffisamment de ressources de calcul.

Des géants comme Amazon (avec AWS Greengrass) ou Microsoft (avec Azure IoT Edge) ont déjà commencé de décliner leur offre logicielle pour les équipements de bordure de réseau (Edge) afin que ceux-ci puissent exécuter certains types de services cloud (apprentissage automatique, analyse…), traiter les données en quasi-temps réel et communiquer avec les capteurs ou d’autres dispositifs auxquels ils sont reliés, même en cas de connectivité intermittente avec le nuage.

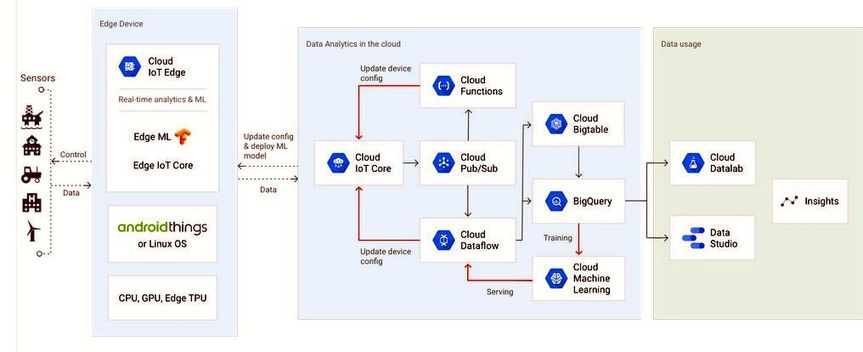

Cet été Google les a rejoints en annonçant deux produits, l’un matériel (un circuit intégré spécifique en l’occurrence, dénommé Edge TPU), l’autre logiciel (Cloud IoT Edge). Cette pile logicielle a vocation à étendre les fonctions d’intelligence artificielle du cloud de Google aux passerelles, caméras et autres équipements connectés. Selon Injong Rhee, vice-président IoT pour l’activité Google Cloud, cette offre permet aux utilisateurs de bâtir et d’entraîner les modèles d’apprentissage automatique dans le nuage puis d’exécuter ces modèles sur l’équipement intégrant la pile Cloud IoT Edge tout en bénéficiant des performances de l’accélérateur matériel Edge TPU (ou d’autres types d’accélérateurs de type CPU ou GPU).

Sourced through Scoop.it from: www.lembarque.com

Leave A Comment