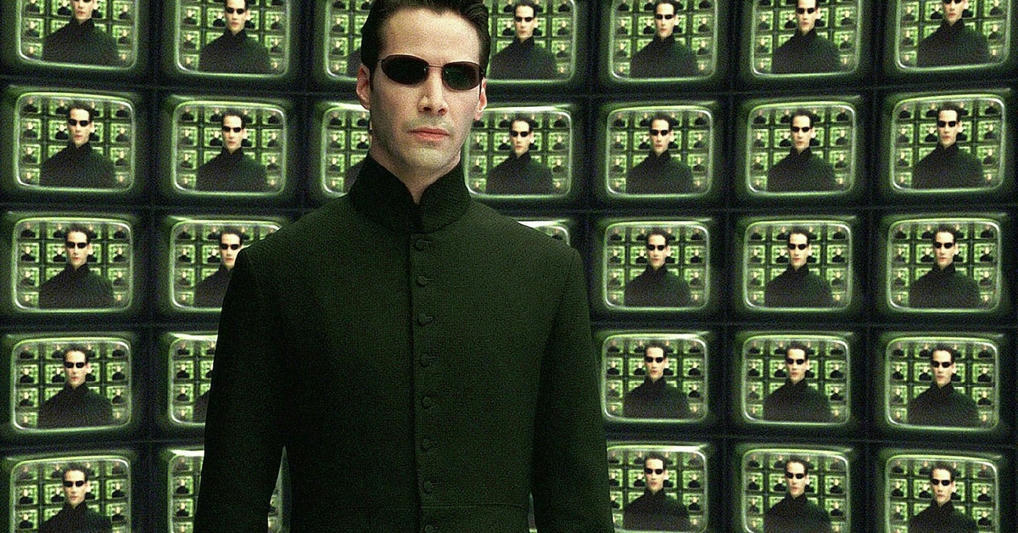

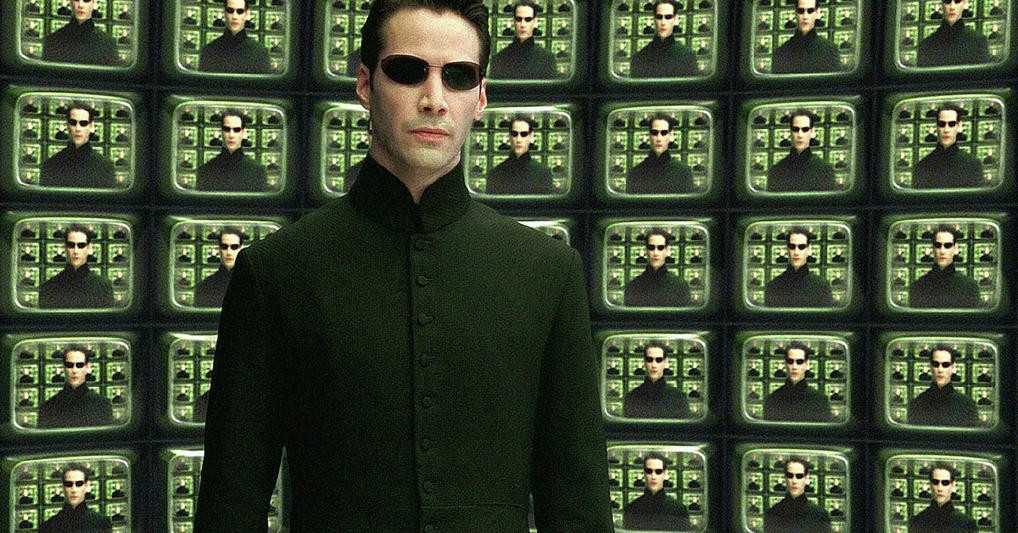

Nightshade, pour troller Midjourney

Nightshade, pour troller Midjourney

Sorte de réponse aux fabricants peu scrupuleux de modèles d’apprentissage automatique, Nightshade a été conçu par des chercheurs de l’université de Chicago. Entièrement gratuit, il a pour objectif d’introduire des perturbations dans les fichiers d’images aspirés illégalement par les IA, afin de générer des erreurs dans les modèles utilisant ces données – au hasard, Midjourney.

Concrètement, en téléchargeant Nightshade, n’importe quel utilisateur peut ainsi transformer une image classique en un « piège » pour les IA grâce à quelques lignes de code invisibles à l’œil nu. Une fois la nouvelle version de l’image postée en ligne, « les modèles qui s’entraînent sur [elle] sans consentement apprendront des comportements imprévisibles qui s’écartent des normes attendues », indiquent les chercheurs, qui citent l’exemple d’une « image d’une vache volant dans l’espace transformée, [aux yeux des IA], en celle d’un sac à main flottant dans l’espace ».

Le projet s’inscrit par ailleurs dans la continuité de Glaze, premier outil conçu par les mêmes chercheurs de The Glaze Project, sorte de « bouclier » de défense contre le style très mimétique des IA. Cette fois, Nightshade a été conçu comme un outil véritablement offensif, capable de déformer les représentations à l’intérieur même des modèles de générateurs d’image par IA. Résultat, « les chiens deviennent des chats, les voitures se transforment en vaches, les chapeaux deviennent des gâteaux », exemplifie L’Usine Digitale. Et l’IA est prise à son propre jeu.

Kudurru, pour stopper les voyous

Pages Tumblr, portfolios, comptes Instagram… Créé par la start-up Spawning.ai, le logiciel Kudurru permet de détecter les tentatives de collecte massive sur n’importe quelle plateforme d’images, procédé extrêmement courant dans le domaine de l’intelligence artificielle.

Concrètement, le modèle de Kudurru permet d’identifier les adresses IP pendant leur tentative d’extraction, puis de leur bloquer l’accès. Ce qui « revient à empoisonner » le modèle d’IA et à amoindrir sa fiabilité, décrit Jordan Meyer, cofondateur de Spawning. Pour y parvenir, l’internaute a le choix entre l’obstruction pure et simple et la redirection vers un autre lien que celui demandé (exemple suggéré : le hit d’Astley Never Gonna Give You Up, devenu symbole du trolling sur les réseaux sociaux).

À l’heure actuelle, plus de mille sites ont déjà été intégrés au réseau Kudurru, selon France Info. L’entreprise Spawning.ai est aussi à l’origine du service Have I Been Trained?, un site en anglais qui permet de vérifier si des données ont déjà été exploitées aux IA, en offrant à leurs propriétaires la possibilité de les protéger contre de futures utilisations.

Photoguard, pour protéger vos photos

Avec Photoguard, le principe est peu ou prou le même : ajouter des « perturbations » invisibles à l’œil nu dans les images que l’on souhaite, afin d’empêcher que celles-ci ne fassent l’objet d’extractions ou de modifications malveillantes. Comme l’indique Radio Canada, il suffit de télécharger sa photo dans l’outil, accessible en ligne, « puis PhotoGuard s’occupe de retoucher certains pixels, imperceptibles à l’œil nu, qui envoient des signaux qui perturbent la lecture de l’algorithme d’IA ».

« À l’heure actuelle, n’importe qui peut prendre notre image, la modifier à sa guise, nous mettre dans des situations très désagréables et nous faire chanter », déplore Hadi Salman, chercheur doctorant au MIT, qui a contribué à la création du projet. Seul bémol, les résultats ne sont pour l’heure « consolidés qu’avec le modèle d’apprentissage Stable Diffusion », d’après l’équipe de recherche. À éviter, donc, si vous craignez plutôt les algorithmes de Midjourney.

AntiFake, pour que votre voix reste unique

Les initiatives de ce type ne se limitent pas aux images et aux textes. Côté données sonores, des chercheurs de l’université de Washington à St. Louis, dans le Missouri, ont mis au point l’outil AntiFake. Celui-ci « empêche les criminels d’utiliser les informations liées à votre voix pour la synthétiser et usurper votre identité », vante l’ingénieur Ning Zhang, l’un des co-créateurs du dispositif.

Pour ce faire, le logiciel enrichit un fichier son original en y ajoutant quelques traces de bruits supplémentaires, imperceptibles à l’oreille humaine, qui rendent impossible l’imitation crédible d’une voix humaine. « Nous modifions le fichier juste assez pour qu’il sonne toujours correctement à l’oreille humaine tout en apparaissant complètement différent aux yeux de l’IA », poursuit Ning Zhang.

Selon Zhiyuan Yu, autre doctorant à l’origine du projet, son équipe a récemment été contactée par les producteurs d’un podcast à succès qui souhaitaient le protéger d’éventuels détournements. Avant, demain, sa généralisation ?

Mockingbird, pour prévenir les deepfakes

Plus conventionnel, le célèbre éditeur de logiciel antivirus McAfee a récemment dévoilé un nouveau projet intitulé Mockingbird, censé « lutter contre l’arnaque au clonage vocal des IA ». Explicitement consacré à prévenir le « fléau des deepfakes », Mockingbird a été dévoilé à la dernière édition du Consumer Electronics Show (CES), qui s’est tenu début janvier à Las Vegas, dans le Nevada.

D’après McAfee, l’outil est capable de différencier un contenu audio authentique d’un fake dans 90 % des cas. Pour parvenir à ce taux de précision, McAfee s’appuie sur une combinaison de modèles de détection animés par l’IA, dont « un modèle structurel, qui analyse le type de menaces, un modèle comportemental, qui s’attarde sur le mode opératoire, et un modèle contextuel, qui remonte aux origines des données derrière l’opération », détaille le média spécialisé 01Net.

Mieux : à l’avenir, la technologie Mockingbird permettra aussi de déceler les contenus vidéo trafiqués en s’attardant sur la véracité de la piste audio. Pour l’heure, ni la prix ni la date de commercialisation de l’outil n’ont été communiqués.

Lire l’article complet sur : usbeketrica.com

Leave A Comment