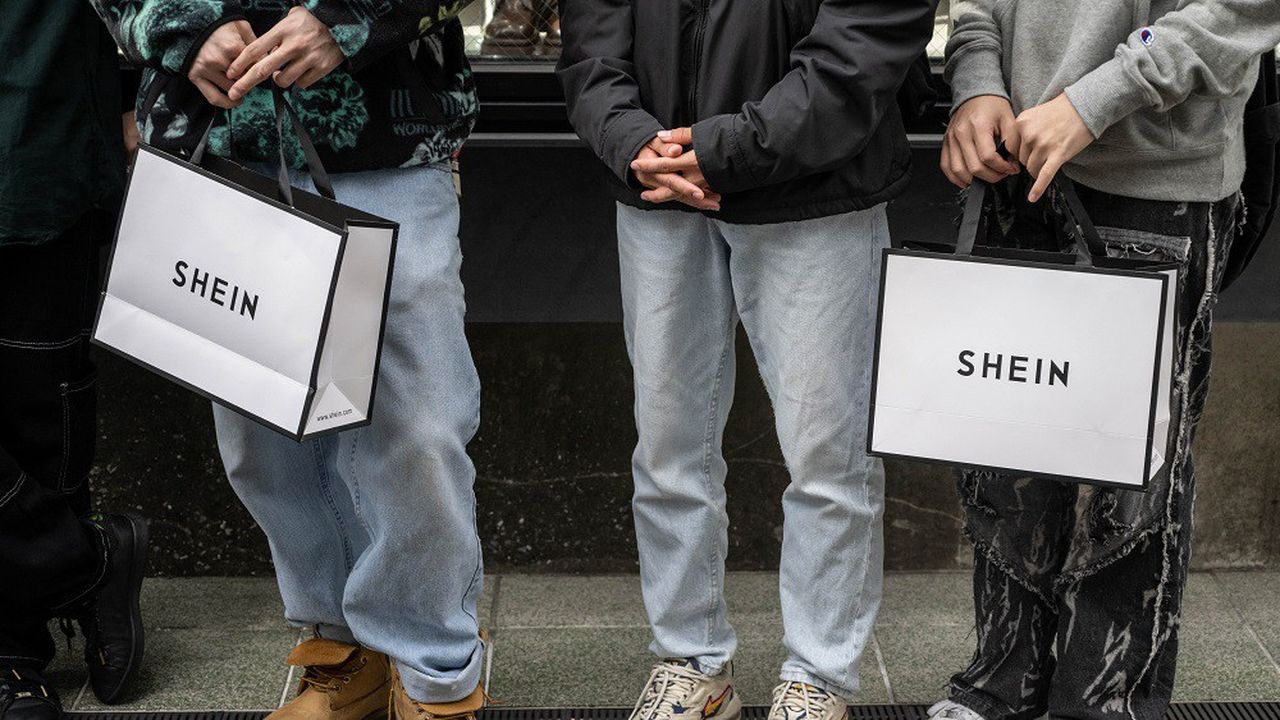

Mode : Shein se rapproche d’une introduction à la Bourse de Londres

La tendance se précise pour Shein. Selon plusieurs médias anglo-saxons, qui citaient lundi des sources proches du dossier, le géant de la « fast fashion » devrait publier dans les jours à venir un projet d'entrée en bourse à environ 60 milliards d'euros à Londres, après avoir renoncé à Wall Street. Le site de vente de vêtements à bas prix, fondé en Chine et installé à Singapour, « prévoit de déposer de façon confidentielle un projet d'entrée en bourse à Londres dans les prochains jours » pour ce qui serait l'une des plus grosses offres boursières des dernières années à la Bourse de Londres, écrit notamment le « Financial Times ». Le quotidien financier, citant des sources proches du dossier, ajoute que ce projet à 50 milliards de livres (soit environ 60 milliards d'euros) serait déposé auprès des régulateurs britanniques pour signifier un souhait de cotation. La chaîne de télévision Sky News précise que cela pourrait avoir lieu dès cette semaine mais pourrait également être remis à plus tard ce mois-ci. Soulagement à la City Ce serait une bonne nouvelle pour la place londonienne , qui fait face à des départs pour Wall Street ou des choix de première cotation outre-Atlantique, où les entreprises espèrent bénéficier de meilleures valorisations et d'un plus vaste accès à des investisseurs. LIRE AUSSI : EXCLUSIF - Shein se lance dans la vente de vêtements d'occasion ENQUÊTE - A Canton, avec les petites mains de Shein Shein envisageait à l'origine une cotation à New York avant d'y renoncer vu un accueil tiède des régulateurs américains, en raison des dissensions entre Washington et Pékin. En février, Sky News écrivait que le ministre des Finances britannique Jeremy Hunt avait discuté avec le président exécutif de Shein, Donald Tang, d'une cotation à Londres. Une griffe aux méthodes discutables Fondé en 2008, le site de vente en ligne Shein a rapidement conquis le marché mondial de la mode éphémère ou « fast-fashion », basée sur le renouvellement rapide de collections à prix cassés, ce qui a séduit de nombreux consommateurs en plein bond d'inflation et crise du pouvoir d'achat. LIRE AUSSI : EN CHIFFRES - Shein engrange deux fois plus de bénéfices que H & M DECRYPTAGE - Pourquoi définir la « fast fashion » reste un casse-tête Accusée de travail forcé, de plagiat de modèles de ses concurrents, d'incitation à la surconsommation, montrée du doigt pour l'impact environnemental de ses produits et peu transparente sur sa production, la marque s'attire les foudres des défenseurs de l'environnement et des droits humains. Le mois dernier, une étude de l'ONG américano-canadienne Stand Earth plaçait Shein à la dernière place d'un classement de l'impact environnemental des marques de « fast fashion ». Ce qui n'a pas empêché l'entreprise de réaliser 23 milliards de dollars de chiffre d'affaires et 800 millions de bénéfices en 2022, selon le quotidien américain « The Wall Street Journal ».

Le transport aérien mondial n’arrive plus à répondre à une demande insatiable

Le transport aérien n'a plus de problème de demande - le trafic mondial devrait approcher les 5 milliards de passagers cette année -, mais il est désormais confronté à un sérieux problème d'offre. Les compagnies aériennes manquent d'avions neufs, de pièces détachées pour la maintenance, de créneaux dans les principaux aéroports, notamment en Europe, et de carburant d'aviation durable pour réduire leurs émissions de CO2. Les représentants des compagnies aériennes, réunis ce lundi à Dubaï pour l'assemblée générale annuelle de l'Association des compagnies aériennes internationales (IATA), disent tous la même chose. Alors que la croissance du trafic est repartie à un rythme supérieur à celle d'avant-Covid, les moyens leur manquent pour pouvoir satisfaire cette demande. Trafic et bénéfices record Ce n'est pas un problème d'argent. Avec le retour en masse des passagers, les tarifs aériens et les bénéfices des compagnies aériennes se sont envolés depuis deux ans. Pour 2024, l'Iata a encore revu à la hausse sa prévision de bénéfices et table désormais sur un bénéfice net record de 30,5 milliards de dollars, contre 27,4 milliards en 2023. Leur chiffre d'affaires cumulé, en hausse de 9,7 % sur un an, devrait frôler, pour la première fois, les mille milliards de dollars, pour un trafic mondial record, de 4,96 milliards de passagers. Ce n'est pas non plus un manque d'anticipation. Les commandes d'avions neufs atteignent également des niveaux records, avec plus de 15.000 avions à livrer pour Airbus et Boeing . Le problème le plus immédiat est celui des retards de livraison d'Airbus et de Boeing. « C'est un sujet de frustration pour tous les dirigeants de compagnies aériennes, souligne le directeur de l'Iata, Willie Walsh. Cela oblige les compagnies à reporter des ouvertures de lignes et à conserver ou à remettre en service des avions anciens. Et cette situation devrait se prolonger jusqu'en 2025, voire 2026 », estime-t-il.

Intelligence artificielle : ces grandes entreprises qui risquent le décrochage –

Près d’1 entreprise sur 10 ne compte pas du tout intégrer l’intelligence générative artificielle (IAG) dans son activité. C’est l’un des enseignements d’une étude réalisée récemment par Opinion Way par le groupe Dékuple portant sur l’appropriation de l’intelligence artificielle générative au sein des entreprises de plus de 250 salariés en France. Si parmi les 300 décisionnaires interrogés, 93 % considèrent que l’IAG est une vraie révolution pour les entreprises, certaines ne sont cependant pas encore actives sur le sujet, constate cette étude. PUBLICITÉ LIRE AUSSI : IA : comment faire de tous les Français des virtuoses dans ce domaine Celle-ci dévoile plusieurs signaux d’un décrochage potentiel face aux avancées très rapides de cette technologie. Tout d’abord, 33 % des entreprises ne prévoient pas d’intégration de l’IAG avant 2025. Ensuite, 30 % des entreprises visent une échéance à seulement 2026, quand 8 % n’ont tout simplement pas prévu de l’intégrer. Seulement 6 % des entreprises ont déjà pleinement intégré l’IAG dans leur organisation. Elles sont d’ailleurs 39 % à n’avoir entamé aucune réflexion ou être seulement au stade de la réflexion sur le sujet de l’IAG. Les entreprises qui n’ont pas encore débuté le processus "doivent y songer le plus rapidement possible sous peine de vivre une nouvelle forme d’ubérisation", met en garde Bertrand Laurioz, PDG de Dékuple, société spécialisée dans l’accompagnement des marques dans leur transition technologique. Les grandes entreprises à la traîne Un vrai retard se crée du côté de certaines grandes entreprises, celles qui comptent plus de 5000 salariés. En effet, 9 % des décisionnaires interrogés pensent que l’IAG n’est pas du tout une vraie révolution pour les entreprises contre 2 % pour l’ensemble des décideurs interrogés. Seulement 63 % des décisionnaires de ces entreprises de plus de 5 000 salariés pensent que l’IAG va nécessiter une réorganisation de leur entreprise, contre 83 % pour l’ensemble des décideurs interrogés. "Force est de constater que pour les grandes entreprises, l’intégration de l’IAG est plus compliquée dans son déploiement pour des raisons de processus plus lourds, de normes à respecter et de coût", explique Bertrand Laurioz, cité dans un communiqué. LIRE AUSSI : Demain, tous super-performants ? Ces trois fantasmes autour de l’intelligence artificielle Les décideurs ayant intégré ou ayant en projet d’intégrer l’intelligence artificielle dans leur entreprise marquent quant à eux le pas : aucune formation des employés n’est prévue pour 13 % d’entre eux, et un chiffre similaire (11 %) pour les managers. Ces indicateurs "peuvent laisser craindre une forme d’attentisme alors que l’IAG impacte d’ores et déjà les entreprises dans leur organisation et leur business", constate le groupe Dékuple. PUBLICITÉ Un budget IAG conséquent Certaines entreprises ne restent toutefois pas les bras ballants. Elles sont ainsi 87 % à avoir prévu un budget IAG dans leur plan d’investissement 2024 et, parmi ces entreprises ayant prévu un budget, 65 % anticipent qu’elles devront investir davantage pour atteindre leur objectif. Près de la moitié des entreprises (48 %) prévoient par ailleurs de consacrer 5 millions d’euros ou plus à l’intégration de l’IAG dans leur organisation. Dans cette perspective, les investissements devraient permettre un gain de productivité d’au moins 20 % pour 6 entreprises sur 10. LIRE AUSSI : Intelligence artificielle : cette start-up prête à s'attaquer au talon d'Achille de l'Europe "Capacité d’innovation, génération de nouvelles idées" et "optimisations et gains de productivité" se situent sur la première et la deuxième marche du podium des cinq principaux avantages attendus de l’IAG, avec des pourcentages respectifs de 51 % et 47 %. Par ailleurs, les décideurs interrogés considèrent que les fonctions supports de l’entreprise, comme la finance, la gestion des ressources humaines ou encore le juridique, tireraient respectivement profit de l’intelligence artificielle générative à hauteur seulement de 28 %, 25 % et 13 %, contre 41 % pour le marketing ou 38 % pour la direction informatique

Le réchauffement climatique freinera la croissance nettement plus que prévu

L'impact du réchauffement climatique sur la croissance économique a déjà fait couler beaucoup d'encre , mais le document de travail que vient de publier le National Bureau of Economic Research (NBER) pourrait bien faire date. Selon ses deux auteurs, Adrien Bilal et Diego Känzig, respectivement économistes à Harvard et à Northwestern University, une hausse de la température mondiale de 1 °C provoquera une baisse du PIB mondial de 12 %, au bout de six ans. Selon eux, le réchauffement de 0,75 °C constaté entre 1960 et 2019 pèse déjà sur l'économie de la planète : sans lui, le PIB mondial serait plus élevé de 37 %. Les deux économistes ont aussi calculé qu'une nouvelle hausse de 2 °C d'ici à 2100 conduirait à une baisse du PIB mondial de 50 %, compte tenu des effets cumulatifs des dommages subis sur la durée. Effondrement économique Dit encore autrement, l'émission d'une tonne de carbone engendre un coût économique de 1.056 dollars (973 euros) : réparation des dégâts après des catastrophes climatiques, destruction de capital, détérioration de la santé, baisse de productivité… « Cet impact est six fois plus élevé que celui qui ressort des analyses économiques menées jusqu'à présent sur le sujet, indique Adrien Bilal, rencontré lors d'un passage à Paris. Et encore, nous avons pris des hypothèses très conservatrices. » En Europe, le coût du carbone est même plutôt aujourd'hui estimé autour de 100 dollars, tandis que l'Agence américaine de protection de l'environnement (EPA) table sur 180 à 190 dollars. LIRE AUSSI : En 2023, le réchauffement climatique a touché des millions d'Européens Réchauffement climatique : des impacts socio-économiques massifs d'ici à 30 ans Même s'il n'a pas encore fait l'objet de relecture par des pairs pour publication « officielle » dans une revue, ce document a déjà été remarqué, et très commenté. « Cette étude est remarquable », relève Thomas-Olivier Léautier, chef économiste chez TotalEnergies, ex-directeur de recherche à Toulouse School of Economics. « Elle réconcilie la littérature économique néoclassique avec la vision des scientifiques, qui se sont longtemps étonnés du faible impact macroéconomique estimé jusque-là. » Xavier Jaravel, professeur à London School of Economics, y a également consacré une chronique dans nos colonnes. Dans les années 1970, le rapport Meadows, écrit par des scientifiques américains, avait été le premier à évoquer les limites des ressources naturelles et à prédire un effondrement économique lorsqu'elles seraient atteintes. Mais les économistes avaient alors opposé à son raisonnement l'absence de prise en compte des prix. « Selon eux, l'économie allait se réguler grâce à l'augmentation des prix liée à la rareté croissante des ressources », explique Thomas-Olivier Léautier.

La blanchisseuse de cryptos piégée par l’achat d’un manoir à 23 millions de livres

La justice britannique sévit contre le phénomène du blanchiment de cryptomonnaies. Une sino-britannique de 42 ans a été condamnée vendredi à six ans et huit mois de prison par un tribunal londonien pour avoir dissimulé l'origine illicite de millions de livres sterling en bitcoins. Entre 2017 et 2020, Jian Wen, ex-employée du secteur de la restauration, a aidé à blanchir le fruit d'une vaste arnaque à l'investissement ayant lésé des dizaines de milliers de particuliers, pour un préjudice total évalué à 5 milliards de livres. La fraude était orchestrée par une autre ressortissante chinoise, Yadi Zhang, pour laquelle elle oeuvrait en convertissant les actifs numériques en cash, bijoux et autres biens de luxe. « Il s'agissait d'une opération sophistiquée qui impliquait une importante planification », a déclaré la juge Sally-Ann Hales lors de l'audience. « Fragile et désespérée » Jian Wen a plaidé non coupable et fermement nié avoir eu connaissance de l'origine réelle des fonds. « Mlle Wen était une femme fragile et désespérée » qui a été « sans aucun doute dupée et utilisée », a plaidé son avocat, Mark Harries KC. Pour le tribunal, il est pourtant clair que la prévenue avait conscience de la nature frauduleuse de ses actes. Son implication dans ce stratagème lui a permis de mener un train de vie luxueux. Jian Wen occupait une maison d'une valeur de plusieurs millions de livres, dans un quartier huppé de Londres.

Streaming : les chaînes boostent leurs plateformes avec l’IA

Depuis l'arrivée de TF1+ en janvier, puis de M6+ ces dernières semaines, les chaînes multiplient les efforts pour émerger dans le streaming gratuit. Contenus, marketing… dans la guerre pour l'attention qui les oppose également aux « streamers » payants à la Netflix, le match se joue aussi sur l'amélioration de l'« expérience utilisateur ». Dans ce but, TF1+ vient de présenter son nouveau moteur de recommandation. Baptisé « Synchro », cet outil à base d'intelligence artificielle (IA) va être déployé progressivement, dès cette semaine sur les téléviseurs connectés puis, courant juin, sur les box des opérateurs télécoms. En accord avec la ligne éditoriale de TF1, son algorithme s'adapte aux usages de tout un foyer. Quant à M6+, la plateforme renouvelée de la Six aura un nouvel outil de recherche des programmes à base d'IA d'ici la fin de l'année. Chez Arte, les équipes de la chaîne franco-allemande développent aussi un outil à base d'IA pour la plateforme Arte.tv. Interrogé également, France Télévisions dit travailler quotidiennement à l'innovation de France.tv mais ne détaille pas ses projets. 11 minutes perdues à choisir quoi regarder Tous cherchent à s'inspirer de Netflix, qui a construit au fil des années un puissant algorithme à base de « machine learning », en croisant les données de visionnage de centaines de millions d'utilisateurs dans le monde entier. Même si chaque « streamer » a son approche, le problème est le même : la « découvrabilité ». Selon une étude Toluna pour TF1, sur l'ensemble des plateformes de streaming, les Français perdent en moyenne 11 minutes à choisir quoi regarder ! LIRE AUSSI : ZOOM - TF1+, M6+ et France.tv rivalisent de marketing pour s'imposer Sur TF1+, qui propose 15.000 heures de contenus à tout moment, Synchro permet d'ores et déjà de constituer un groupe - jusqu'à cinq personnes - et ensuite choisir. L'algorithme conçu par TF1 (qui a mobilisé une cinquantaine d'ingénieurs, data scientists…) se fonde sur une IA qui retient les historiques de chaque connexion et ajuste en conséquence les propositions en page d'accueil.

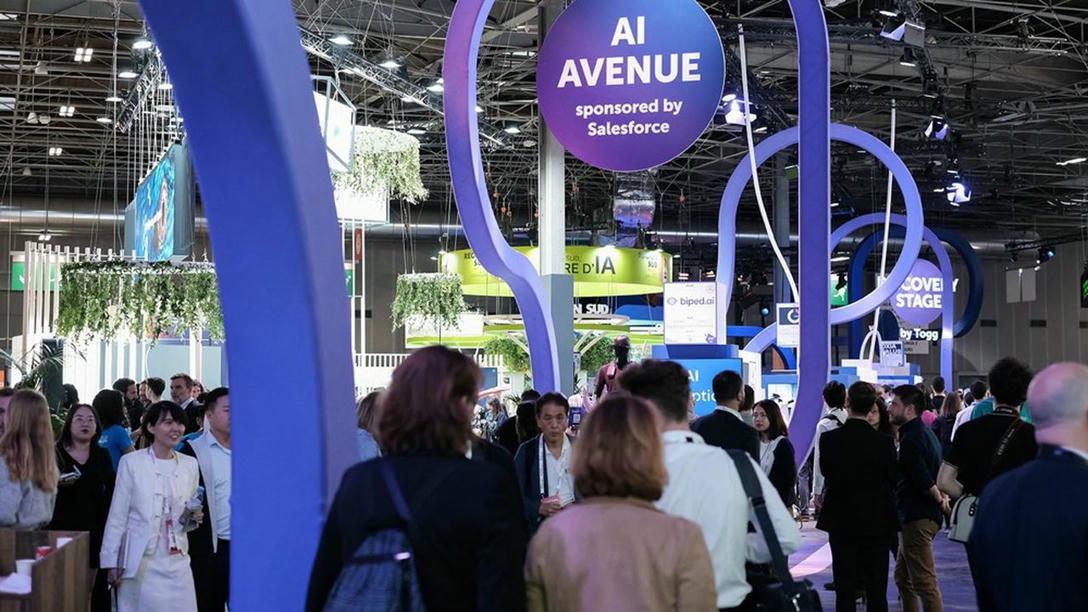

Que retenir de Viva Tech 2024 ? –

Il est toujours difficile de parler de tendances dans un salon où il y a tant de thématiques différentes. Il y a bien sûr l’intelligence artificielle et en particulier l’IA générative. Elle était présente à plusieurs niveaux de maturité. Il y avait à la fois des projets de recherches et des solutions relativement matures qui essayent de trouver des grands intégrateurs pour les accompagner dans leur développement commercial. Mais dire que l’IA est partout c’est aussi dire qu’elle est nulle part. Elle est diffuse dans un salon qui ne parle que d’innovation et de transformation. Et quand il y a de l’IA, il y a aussi de la data. Si les entreprises n’ont pas suffisamment de données suffisamment structurées et qualifiées, l’intelligence artificielle n’aura pas la valeur qu’on peut en attendre. Le Vivant était aussi une grande thématique. Beaucoup de chercheurs reviennent à des solutions bio-inspirées et les entreprises s’inspirent de la nature pour répondre à des besoins. Elles montrent qu’elles répondent aux défis à venir, que ce soit en termes de durabilité mais aussi d’inclusion, avec des projets qui tentent de réparer des handicaps. BiPed AI par exemple propose un harnais doté d’IA à destination des personnes malvoyantes. Quant à la mobilité, elle était moins marquée que les années précédentes. C’est moins un « car electronic show » qu’auparavant, mais on a vu beaucoup de projets autour de la mobilité douce avec Skwheel et Curvway notamment, des skis et des surfs électriques. Tesla exposait pour la première fois pour présenter son Cybertruck, mais les constructeurs automobile étaient peu présents. Quelle est la teneur des solutions présentées cette année ? Y a-t-il eu beaucoup de gadgets ? Je pense qu’il y a eu un retour à des projets très orientés science et ingénierie. C’est un Viva plus deep tech. On ne voit plus autant de gadgets qu’il y a quelque années. Les niveaux de maturité des solutions sont extrêmement variables. Pour la biotech ou la beauty tech par exemple, il y avait autant de choses à voir sur le stand de L’Oréal ou LVMH que chez des petites startups qui traitent de sujets spécifiques. L’une d’entre elle travaille sur l’analyse de peau par exemple, pour identifier des pathologies via les grains de beauté. Sur le stand du Japon, une société travaille autour de la fertilisation des sols. Elle a mis au point un polymère 100% naturel qui va permettre d’augmenter la rétention d’eau de plus de 40%. Il n’y pas un stand qui se contente d’une maquette 3D pour présenter son produit. Chaque produit est le résultat de l’assemblage d’une dizaine de briques technologiques. Le salon Viva Tech est-il en train de concurrencer le CES ? Je pense que le salon demande désormais une préparation similaire à celle du CES. Il reste une différence néanmoins : au salon de Las Vegas, ce sont les marques qui déposent leur contenu sur le site internet, on est donc très dépendants de ce qu’on va y trouver. Il est facile de se perdre en moins de trois jours à Viva Tech. Dix startups peuvent traiter du même sujet, mais avec des degrés de maturité et des angles différents. Il faut savoir d’où elles viennent pour comprendre leur valeur ajoutée. Cette trajectoire qu’arrive à pendre la salon, cette densité d’acteurs, cette capacité à inviter de grands speakers, font que Viva Tech s’est trouvé une place dans un écosystème déjà bien saturé. Le fait de proposer des conférences sur chaque stand, d’apporter du contenu menant à des échanges, apporte une vraie valeur ajoutée. Et dans certain aspects, je pense que le CES s’en inspire désormais.

IA : Traduction, éducation, handicap… 5 start-up repérées à VivaTech

Pyannote, la reconnaissance vocale open source Lancée il y a six semaines, la start-up PyannoteAI développe des modèles d'intelligence artificielle vocale. Objectif : réussir la « diarisation », à savoir, déterminer automatiquement qui parle et quand ? dans un enregistrement audio ou vidéo. « Le modèle s'attache au son, au timbre de la voix et non pas à la langue. Nous avons des utilisateurs allemands, américains, russes, indiens… » précise Vincent Molina, le cofondateur. Issue des recherches du CNRS , la technologie est disponible librement. « Ma mission était de diffuser la savoir. J'avais tout mis dans une bibliothèque open source. Des milliers d'entreprises utilisaient mes travaux de recherche », précise Hervé Bredin, cofondateur de la société et chercheur au CNRS. L'outil est disponible en freemium, avec un abonnement pour les cas d'usage professionnels. La start-up pourrait cibler les marchés de la transcription, de l'audiovisuel ou du secteur de la santé, notamment dans les consultations médecin-patient, dans un environ fermé, grâce à une API ou en local. A VivaTech, la start-up a remporté le « Deeptech Challenge Pitch Contest ». Stellia, l'assistant qui enseigne Stellia. AI développe un « assistant de connaissance » personnalisé grâce à l'intelligence artificielle générative, utilisant les LLM (grands modèles de langage), en particulier dans le domaine de l'éducation. La start-up de 25 employés contractualise avec l'enseignement supérieur, comme le Centre national d'enseignement à distance et des universités américaines. LIRE AUSSI : IA, licornes… Après deux années de crise, la French Tech repart de plus belle Une dotation de 70 millions pour la formation de l'élite de l'IA en France Pour faciliter son déploiement, elle cherche à se diversifier. « L'objectif est de développer la partie privée, en particulier les grands groupes et leurs salariés. Ensuite, nous continuons de développer la tech pour aller vers plus de personnalisation et prendre en compte le profil de chaque utilisateur », confie Samy Lahbabi, le cofondateur de la start-up, incubée à l'Ecole polytechnique. La start-up a levé 4 millions d'euros en 2022 auprès des fonds Innovacom et Inco Ventures. NcodiN, le composant derrière l'IA L'intelligence artificielle connaît un essor spectaculaire et est favorisée par le développement de microprocesseurs de plus en plus puissants. « Or, la limite qui bloque la scalabilité de la circulation de l'information dans les microprocesseurs, c'est le cuivre », rappelle Francesco Manegatti, le patron de NcodiN, une start-up qui s'appuie sur les travaux de recherche qu'il a menés au Centre de nanosciences et de nanotechnologies (C2N). NcodIn entend briser ce « mur du cuivre » en développant des composants reposant sur une technologie d'interconnexion optique. La promesse ? Permettre une transmission de données à haute vitesse et de façon plus sobre. Les prototypes de NcodiN sont fabriqués dans la salle blanche du C2N. « C'est un avantage unique puisque cela nous permet de fabriquer une puce en trois semaines et donc d'accélérer notre R&D. Cela aide aussi à développer des preuves de concept pour les clients », rembobine le dirigeant, qui espère vendre ses produits à des sociétés comme Intel, Nvidia, Qualcomm ou AMD. Biped, l'IA au service du handicap Bruno Vollmer et Maël Fabien ont créé en 2020 Biped.ia, une start-up qui propose un harnais porté sur les épaules pour accompagner les personnes malvoyantes et aveugles lors de leurs déplacements. Equipé de trois caméras grand-angle et infrarouges, l'appareil permet d'avoir une vision à 70° et d'être utilisé la nuit. Le harnais peut se connecter à des écouteurs ou à un casque afin d'avertir l'utilisateur des obstacles avec des sons spatiaux. Grâce à des algorithmes d'IA, cet appareil de moins d'un kilo décrit l'environnement. Il permet d'identifier des obstacles à plus de cinq mètres de distance, placés au niveau de la tête (branche, panneau de signalisation, etc.), au niveau du sol (trous, pierres, etc.) et les obstacles latéraux. Après deux ans de R&D, Biped.ia est entrée en phase de commercialisation, dans un premier temps avec 50 unités. L'objectif sur l'année est de 200 unités, vendues au prix de 4.300 euros. L'entreprise installée à Lausanne, en Suisse, a déjà levé 2,6 millions d'euros. Lipitt, l'outil pour doubler les vidéos La traduction est un secteur secoué par la révolution de l'intelligence artificielle. La preuve avec la jeune pousse allemande DeepL , qui vient de lever 300 millions de dollars sur une valorisation de 5 milliards de dollars. En France, cela bouge aussi. Créée en juillet 2023, Lipitt est une solution de traduction consacrée à la vidéo. Dans le détail, la jeune pousse a développé une plateforme qui, en un clic, permet de traduire des vidéos avec des sous-titres. La start-up, qui travaille notamment avec Gladia, fait aussi du clonage de voix et de la synchronisation labiale afin de rendre l'expérience encore plus fluide. « Nous faisons de la traduction en trente langues », précise son fondateur, Antoine Ménager, qui avait vendu sa précédente société (Signifia) en 2022.

L’énergie, l’autre goulet d’étranglement des champions de l’IA

L'accès incertain et à prix prohibitif aux processeurs graphiques (GPU) les plus puissants de Nvidia n'est pas le seul problème qu'affrontent les champions de l'intelligence artificielle. Portés par des investissements tous azimuts, start-up et Big Tech courent aussi après… l'électricité. C'est une évidence, la tech ne peut rien sans quelques watts. Mais il en faut beaucoup pour l'intelligence artificielle, et notamment celle capable de générer du texte ou de l'image comme ChatGPT. La voracité énergétique des modèles d'IA de Microsoft, OpenAI, Google, Meta, Mistral AI, Anthropic et d'autres est telle qu'elle pourrait bloquer le développement de cette technologie prometteuse. « Un prompt pour du texte est dix fois plus énergivore qu'une requête classique sur un moteur de recherche », souligne Grégory Lebourg, le directeur des programmes environnementaux du français OVHcloud, en s'appuyant sur des travaux universitaires. Si la commande adressée à l'IA vise à lui faire générer une image, les serveurs consomment en quelques secondes l'équivalent d'une charge complète d'un smartphone, explique par ailleurs une étude conjointe de Hugging Face, du Carnegie Mellon University et de l'Allen Institute for AI. Dans l'attente d'une percée scientifique Sam Altman, le PDG et cofondateur d'OpenAI, a lui-même mis le sujet en lumière, en janvier à Davos. « Nous n'apprécions pas encore bien les besoins en énergie de cette technologie », a-t-il prévenu, en se plaçant dans la perspective d'un déploiement plus large qu'aujourd'hui. LIRE AUSSI : ENQUÊTE - Anthropic, le chevalier blanc de l'IA En clair, l'amélioration des grands modèles de langage comme GPT, Gemini, Llama ou Mistral Large ne suffira donc pas pour rendre viable une IA capable de raisonner au service de l'humanité ou au moins de servir d'assistant personnel à tout un chacun. « Il n'y a aucun moyen d'y parvenir sans une percée scientifique », faisait-il remarquer, catégorique. Joignant l'acte à la parole, Sam Altman est depuis longtemps investisseur dans de nouvelles technologies énergétiques, notamment la fusion nucléaire via la start-up Helion. Efficience énergétique à tous les étages « Il va falloir aussi de l'innovation en matière d'efficience énergétique, de refroidissement des serveurs informatiques, de conception des centres de données », confirme Antonio Neri, le patron de Hewlett Packard Enterprise, la vénérable entreprise américaine numéro un mondial des supercalculateurs. De passage à Paris pour VivaTech, il assure aux « Echos » que les laboratoires de son groupe regorgent de prototypes, autant pour limiter la chauffe de ses produits - quitte à les immerger complètement dans l'eau - que pour optimiser la consommation électrique des serveurs. Avec notamment l'idée de paramétrer de plus en plus finement les machines, en fonction de la taille et de la complexité des modèles. Et sans recourir automatiquement à des GPU très gourmands. Des ambitions contrariées Malgré ces innovations, les plans d'ouverture de nouveaux centres de données dans le monde entier se heurtent par endroits, y compris aux Etats-Unis, à des difficultés d'approvisionnement en énergie. De fait, l'IA se développe au même moment où la voiture s'électrifie et où les pompes à chaleurs se répandent dans les foyers. LIRE AUSSI : DECRYPTAGE - Data center : poussée de fièvre sur les demandes de raccordement au réseau électrique Data center : Amazon va investir 15 milliards d'euros en Espagne En France, pour le moment, le sujet est loin d'être critique : les data centers consomment environ 2 % de la production d'électricité nationale. Selon RTE, cette proportion devrait se limiter à 3 %, voire 4 % à l'horizon 2030-2035. Mais comme ailleurs dans le monde, les tensions sur les raccordements électriques des nouveaux data centers pèsent sur les délais affichés par les nouveaux projets. Vers le centre de données 1 GW « L'an dernier, et cela sera pareil en 2024, les data centers ont été à l'origine de 6 gigawatts de nouveaux projets dans le monde, soit deux fois plus qu'en 2022 », note Olivier Micheli, le directeur général de l'opérateur de centres de données Data4. Certains projets sont tout simplement inédits pour tout le monde. « Des centres de données atteindront probablement la barre du gigawatt », notait encore Luc Rémont, le président-directeur général d'EDF, sur la scène de VivaTech. Tout ceci a bien entendu un coût carbone élevé. Ainsi, le développement de Microsoft dans l'IA lui vaut de s'éloigner de son objectif de neutralité carbone en 2030. « A bien des égards, la Lune est cinq fois plus éloignée qu'elle ne l'était en 2020, si l'on pense simplement à nos propres prévisions concernant l'expansion de l'IA et ses besoins en électricité », a récemment reconnu Brad Smith, le patron des affaires publiques de Microsoft. Un fort intérêt pour le nucléaire Le coût de la rareté de l'énergie est aussi sonnant et trébuchant. Avec cette contrainte de se fournir en courant mais autant que possible en courant propre, les enchères montent. Microsoft a, par exemple, signé un partenariat avec le fond d'infrastructure Brookfield pour pouvoir bénéficier des fruits d'un investissement à 10 milliards de dollars dans des projets de production d'énergie solaire et éolienne. Sur ce même front de l'énergie, le géant de Redmond avait aussi publié une offre d'embauche pour un spécialiste des petits réacteurs nucléaires (SMR)… Du côté d'Amazon, le rachat d'un centre de données en Virginie s'est récemment accompagné d'un contrat de long terme avec la centrale nucléaire voisine.

GDPR : L’hospitalité des marques fait loi en Europe.

GDPR : L’hospitalité des marques fait loi en Europe.

Selon une étude récente de la Commission Européenne(3), 72% des Européens s’inquiètent en effet de laisser trop de données personnelles aux entreprises, souvent à leur insu, et surtout de ne pas en recevoir de réelle contrepartie. D’ailleurs, la connaissance plus précise du client semble ne faciliter en rien la capacité de l’entreprise à mieux cibler ses offres : selon tous les indicateurs(4), le taux d’ouverture des mails diminue alors que les désabonnements (opt-out) augmentent, ce qui fragilise largement la rentabilité des investissements lourds consentis dans le CRM.

Selon une étude récente de la Commission Européenne(3), 72% des Européens s’inquiètent en effet de laisser trop de données personnelles aux entreprises, souvent à leur insu, et surtout de ne pas en recevoir de réelle contrepartie. D’ailleurs, la connaissance plus précise du client semble ne faciliter en rien la capacité de l’entreprise à mieux cibler ses offres : selon tous les indicateurs(4), le taux d’ouverture des mails diminue alors que les désabonnements (opt-out) augmentent, ce qui fragilise largement la rentabilité des investissements lourds consentis dans le CRM. Accueillir un consommateur “libre” est sans doute une perspective qui effraie bon nombre de marques, tant elle ont été construites sur la notion d’un marketing manipulateur et insidieux, capable d’influencer jusqu’aux émotions pour enfermer les clients dans un tunnel de vente dont la seule issue est l’achat du produit. Avec la GDPR, ce n’est plus le produit qu’il va falloir vendre, c’est la marque qui doit apprendre à se faire acheter. Et pour cela, il va falloir qu’elle se montre hospitalière vis à vis de ses clients : bienveillante, humaine et proche.

Accueillir un consommateur “libre” est sans doute une perspective qui effraie bon nombre de marques, tant elle ont été construites sur la notion d’un marketing manipulateur et insidieux, capable d’influencer jusqu’aux émotions pour enfermer les clients dans un tunnel de vente dont la seule issue est l’achat du produit. Avec la GDPR, ce n’est plus le produit qu’il va falloir vendre, c’est la marque qui doit apprendre à se faire acheter. Et pour cela, il va falloir qu’elle se montre hospitalière vis à vis de ses clients : bienveillante, humaine et proche. Ce serait peine perdue pour les marques que de se contenter de « mettre en conformité » leur bases de données tout en espérant garder les mêmes pratiques relationnelles. Car la GDPR est d’abord une invitation à renverser ses pratiques relationnelles pour faire montre d’hospitalité vis à vis de ses clients ; et c’est ce renversement d’attitude qui est lui même porteur de croissance pour les marques. Avec la GDPR, l’hospitalité ouvre pour les marques de nouvelles perspectives de croissance.

Ce serait peine perdue pour les marques que de se contenter de « mettre en conformité » leur bases de données tout en espérant garder les mêmes pratiques relationnelles. Car la GDPR est d’abord une invitation à renverser ses pratiques relationnelles pour faire montre d’hospitalité vis à vis de ses clients ; et c’est ce renversement d’attitude qui est lui même porteur de croissance pour les marques. Avec la GDPR, l’hospitalité ouvre pour les marques de nouvelles perspectives de croissance.